本篇目录:

- 1、Spark的shuffle和MapReduce的shuffle对比

- 2、Hadoop读写文件时内部工作机制是怎样的

- 3、mapreduce计算的主要流程有哪些

- 4、简单搞定Shuffle机制运行原理

- 5、hadoop中存储文件系统hdfs的冗余机制是怎么进行的?有什么特点?

- 6、如何用Matlab画出一个二阶段随机过程

Spark的shuffle和MapReduce的shuffle对比

MapReduce和Spark的主要区别在于数据处理方式和速度。Spark使用内存计算,而MapReduce使用硬盘计算,因此Spark在处理大数据时通常更快。 数据处理方式 MapReduce和Spark都是大数据处理技术,但它们的处理方式存在显著的差异。

它分为两个阶段:Map阶段和Reduce阶段。Map阶段处理数据,然后生成中间结果,Reduce阶段则对这些中间结果进行汇总。Spark,全称Apache Spark,是一个开源的大规模数据处理计算框架。

Spark相比MapReduce的优势主要体现在以下几个方面:Spark是基于内存的,而MapReduce是基于磁盘的,这使得Spark的I/O开销更小,计算速度更快。

Spark核心RDD Spark能够实现对MapReduce性能的直线超越,得益于Spark中一种名为RDD(Resilient Distributed DataSets)的数据处理模型。

MapReduce与Spark相比,有哪些异同点 基本原理上: a) MapReduce:基于磁盘的大数据批量处理系统。

shuffle和排序: MapReduce确保每个Reducer的输入都是按键排序的。系统执行排序的过程-将map输出作为输入传给reducer的过程称为shuffle。shuffle属于不断被优化和改进的代码库的一部分,从许多方面来看,shuffle是MapReduce的心脏。

Hadoop读写文件时内部工作机制是怎样的

HDFS使用分布式存储技术,将文件切分成多个块,并且存储在不同的服务器节点上,各个服务器通过网络进行通信,实现文件的存储和读取;另外,HDFS具有重复备份机制,对文件进行多次备份以提高文件的可靠性。

组成。通过对Hadoop分布式计算平台最核心的分布式文件系统HDFS、MapReduce处理过程,以及数据仓库工具Hive和分布式数据库Hbase的介绍,基本涵盖了Hadoop分布式平台的所有技术核心。

写出缓冲区:collect将缓冲区的内容写出时,会调用sortAndSpill函数,这个函数作用主要是创建spill文件,按照key值对数据进行排序,按照划分将数据写入文件,如果配置了combiner类,会先调用combineAndSpill函数再写文件。

同时,分布式存储系统还需要提供高效的数据访问接口,以便用户能够方便地读取和写入数据。 Hadoop:Hadoop是处理大数据的一个开源软件框架,它包括HDFS(分布式文件系统)和MapReduce(分布式计算框架)两个核心组件。

HDFS的元数据的介绍(三个部分):HDSF元数据的存储位置:手动退出或者进入安全模式 集群启动后:将每个文件的数据进行分块存储,每一个数据块又保存有多个副本,这些数据块副本分布在不同的机器节点上。

在集群资源紧缺的情况下,设计合理的推测执行机制可在多用少量资源情况下,减少大作业的计算时间。

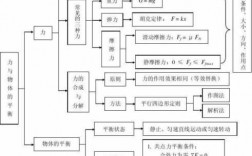

mapreduce计算的主要流程有哪些

1、输入:输入数据分为键/值对,由集群中的每个节点处理。映射函数:使用输入数据中的每个键/值对来调用用户定义的映射函数,以生成一组中间键/值对。Shuffle:将中间的键/值对分组,并将其发送到正确的节点。

2、mapreduce工作流程如下:输入分片(input split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身。

3、处理一个mapreduce作业主要包括的过程如下:输入数据切片 在开始执行作业之前,输入数据会被切片成若千个小块。每个小块通常大小为64MB-128MB左右。Map任务执行 每个Worker节点会启动若个Mapper线程来处理输入数据切片。

4、MapReduce是分布式计算框架,由Google提出,主要用于解决海量数据的计算问题。 MapReduce运行的时候,会通过Mapper运行的任务读取HDFS中的数据文件,然后调用自己的方法,处理数据,最后输出。

5、(1) 首先从HDFS中读取数据,并对它做分片操作(split) (2) 每个小分片单独启动一个map任务来处理此分片的数据。

简单搞定Shuffle机制运行原理

当mapreduce任务提交后,reduce task就不断通过RPC从JobTracker那里获取map task是否完成的信息,如果获知某台TaskTracker上的map task执行完成,Shuffle的后半段过程就开始启动。

算法原理 下列动图来自五分钟学算法,演示了快速排序算法的原理和步骤。

分为2个步骤,map和reduce,map专门负责对每个数据独立地同时地打标签,框架会对相同标签的数据分成一组,reduce对分好的那些组数据做累计计算。

对于关系的选择运算,只需要Map过程就能实现,对于关系R 中的每个元组t,检测是否是满足条件的所需元组,如果满足条件,则输出键值对,也就是说,键和值都是t。

对齐操作只会发生在拥有多输入运算(join)或者多个输出(repartition、shuffle)的算子的场景下。所以,对于只有 map()、flatmap()、fliter() 等并行操作即使在至少一次的模式中仍然会保证严格一次。

hadoop中存储文件系统hdfs的冗余机制是怎么进行的?有什么特点?

分布式存储:HDFS是一个分布式文件系统,可以在多个节点上进行数据存储。这意味着数据不是存储在一个单一的服务器上,而是分布在多个服务器上。这种设计不仅提高了数据存储的容量,也增强了系统的可靠性。

HDFS的特点 简单一致性模型 大部分的HDFS程序对文件操作需要的是一次写多次读取的操作模式。一个文件一旦创建、写入、关闭之后就不需要修改了。

支持海量数据的存储:一般来说,HDFS存储的文件可以支持TB和PB级别的数据。检测和快速应对硬件故障:在集群环境中,硬件故障是常见性问题。

HDFS使用分布式存储技术,可以有效地提升存储能力和数据的可靠性,同时也可以支持对大数据的高速读写操作。在Hadoop大数据平台中,HDFS作为底层存储系统,扮演着至关重要的角色。

HDFS (Hadoop Distributed File System)是 Hadoop 的核心组件之一, 非常适于存储大型数据 (比如 TB 和 PB), HDFS 使用多台计算机存储文件,并且提供统一的访问接口,像是访问一个普通文件系统一样使用分布式文件系统。

hdfs的文件副本机制? 所有的文件都是以块的形式保存到hdfs中。块的大小默认为128m。在hdfs-site文件中进行指定。

如何用Matlab画出一个二阶段随机过程

1、启动matlab,主界面如图所示,在命令行窗口中直接键入代码。代码如下图所示。可以看到matlab自动为其选择了不同个颜色进行区分,但是并不容易看出那条曲线是那个函数的。下面通过定点标记,来给出明显的区分。

2、首先我们选择鼠标单击打开MATLAB工作界面。选择下面显示的Simulink按钮以打开Simulink工作环境。Simulink设备库可以包含图中数字2的列表。在设备库中,库中包含子设备,请参见图中的标签3。

3、根据状态的逗留时间分布可以随机产生时间,根据这个时间就可以模拟出随机过程了。

4、可以自己定义的,比如从荷叶推断天气时,状态1 荷叶很干 状态2 荷叶干 状态3 荷叶湿润, 状态4荷叶很湿。。等等 根据自己需求定义即可。不知道说的对不对,建议去看 随机过程 里面讲了HMM模型。

到此,以上就是小编对于shuffle 过程的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏