本篇目录:

- 1、Hadoop从入门到精通33:MapReduce核心原理之Shuffle过程分析

- 2、MapReduce执行过程

- 3、mapreduce工作流程

- 4、请简要描述Hadoop计算框架MapReduce的工作原理

- 5、mapreduce的工作流程

Hadoop从入门到精通33:MapReduce核心原理之Shuffle过程分析

1、从运算效率的出发点,map输出结果优先存储在map节点的内存中。

2、Map端的Shuffle过程到此结束。 Reduce任务拖取某个Map对应的数据,如果在内存中能放得下这次数据的话就直接把数据写到内存中。

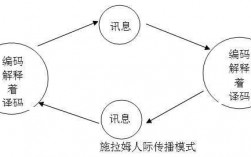

3、在map中,每个 map 函数会输出一组 key/value对, Shuffle 阶段需要从所有 map主机上把相同的 key 的 key value对组合在一起,(也就是这里省去的Combiner阶段)组合后传给 reduce主机, 作为输入进入 reduce函数里。

4、MapReduce里的Shuffle:描述着数据从map task输出到reduce task输入的这段过程。 Map端流程分析 1 每个输入分片会让一个map任务来处理,默认情况下,以HDFS的一个块的大小(默认64M)为一个分片,当然我们也可以设置块的大小。

5、从全局上来看,MapReduce就是一个分布式的GroupBy的过程。 从上图可以看到,Global Shuffle左边,两台机器执行的是Map。Global Shuffle右边,两台机器执行的是Reduce。 Hadoop会将输入数据划分成等长的数据块,成为数据分片。

6、Map Reduce定义 Map Reduce是一个分布式运算程序的编程框架,是用户开发“基于Hadoop的数据分析应用”的核心框架。

MapReduce执行过程

1、上面描述的过程是从数据流角度看。而从系统角度看,MapReduce运行用户编写的应用程序过程如下:用户启动MapReduce后,程序会被部署到不同的机器上去。

2、其实不管在map端还是在reduce端,MapReduce都是反复地执行排序,合并操作,现在终于明白了有些人为什么会说:排序是hadoop的灵魂。

3、图3-3 MapReduce任务执行流程示意图 图3-4 Shuffle过程基本流程图 输入的数据执行map任务后,会先写入到本地缓存中(缓存默认大小是100M),缓存数据达到溢写比(默认是0.8)后,会溢写到本地磁盘中。

4、分为2个步骤,map和reduce,map专门负责对每个数据独立地同时地打标签,框架会对相同标签的数据分成一组,reduce对分好的那些组数据做累计计算。

5、总之,在MapReduce的计算模型中,任务分解是实现高性能、高并发处理大数据集的关键环节,需要JobTracker负责分配和协调任务的执行过程。MapReduce简介:MapReduce是一种编程模型,用于大规模数据集的并行运算。

6、shuffle,即混洗、洗牌的意思,是指MapReduce程序在执行过程中,数据在各个Mapper(Combiner、Sorter、Partitioner)、Reducer等进程之间互相交换的过程。 关于上图Shuffle过程的几点说明: 说明:map节点执行map task任务生成map的输出结果。

mapreduce工作流程

1、mapreduce工作流程如下:输入分片(input split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身。

2、map任务的输入和输出都是key-value (3) 把每个map输出的key-value都进行分区,然后做排序、归并、合并后,分发给所有reduce节点去处理——这个过程称为shuffle。因此map输出的分区数量取决于reduce机器(节点)的数量。

3、其实,一次mapreduce过程就包括上图的6个步骤,input、splitting、mapping、shuffling、redecing、final redult。

4、MapReduce里的Shuffle:描述着数据从map task输出到reduce task输入的这段过程。 Map端流程分析 1 每个输入分片会让一个map任务来处理,默认情况下,以HDFS的一个块的大小(默认64M)为一个分片,当然我们也可以设置块的大小。

请简要描述Hadoop计算框架MapReduce的工作原理

1、分为2个步骤,map和reduce,map专门负责对每个数据独立地同时地打标签,框架会对相同标签的数据分成一组,reduce对分好的那些组数据做累计计算。

2、hadoop是依据mapreduce的原理,用Java语言实现的分布式处理机制。

3、hadoop原理:其最底部是 Hadoop Distributed File System(HDFS),它存储 Hadoop 集群中所有存储节点上的文件。HDFS的上一层是MapReduce 引擎,该引擎由 JobTrackers 和 TaskTrackers 组成。

4、(1)map task任务执行,输入数据的来源是:HDFS的block。当然在mapreduce概念中,map task读取的是split分片。split与block的对应关系:一对一(默认)。

5、Hadoop MapReduce 其实就是Google MapReduce的一个克隆版本。Hadoop 0即第二代Hadoop系统,其框架最核心的设计是HDFS、MapReduce和YARN。其中,HDFS为海量数据提供存储,MapReduce用于分布式计算,YARN用于进行资源管理。

mapreduce的工作流程

mapreduce工作流程如下:输入分片(input split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身。

map任务的输入和输出都是key-value (3) 把每个map输出的key-value都进行分区,然后做排序、归并、合并后,分发给所有reduce节点去处理——这个过程称为shuffle。因此map输出的分区数量取决于reduce机器(节点)的数量。

MapReduce存在以下4个独立的实体。 JobClient:运行于client node,负责将MapReduce程序打成Jar包存储到HDFS,并把Jar包的路径提交到Jobtracker,由Jobtracker进行任务的分配和监控。

具体来说,JobTracker负责任务分解的主要流程如下:首先,JobTracker会根据用户指定的Map数量来计算如何将数据集分块。

分为2个步骤,map和reduce,map专门负责对每个数据独立地同时地打标签,框架会对相同标签的数据分成一组,reduce对分好的那些组数据做累计计算。

到此,以上就是小编对于mapreduce20体系主要由哪几个部分组成的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏