本篇目录:

mapreduce工作原理

1、分为2个步骤,map和reduce,map专门负责对每个数据独立地同时地打标签,框架会对相同标签的数据分成一组,reduce对分好的那些组数据做累计计算。

2、当mapreduce任务提交后,reduce task就不断通过RPC从JobTracker那里获取map task是否完成的信息,如果获知某台TaskTracker上的map task执行完成,Shuffle的后半段过程就开始启动。

3、sqoop的原理比较简单,就是根据用户指定的sql或者字段参数,从数据库中读取数据导入到hive或者hdfs中。也支持基于数据库导出工具导出,不过受限于数据库的版本。在导出的过程中,sqoop会自动切分mapreduce任务。

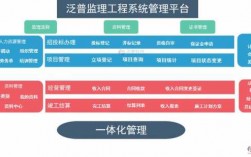

MapReduce工作流程最详细解释

mapreduce工作流程如下:输入分片(input split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身。

输入:输入数据分为键/值对,由集群中的每个节点处理。映射函数:使用输入数据中的每个键/值对来调用用户定义的映射函数,以生成一组中间键/值对。Shuffle:将中间的键/值对分组,并将其发送到正确的节点。

map任务的输入和输出都是key-value (3) 把每个map输出的key-value都进行分区,然后做排序、归并、合并后,分发给所有reduce节点去处理——这个过程称为shuffle。因此map输出的分区数量取决于reduce机器(节点)的数量。

MapReduce运行的时候,会通过Mapper运行的任务读取HDFS中的数据文件,然后调用自己的方法,处理数据,最后输出。Reducer任务会接收Mapper任务输出的数据,作为自己的输入数据,调用自己的方法,最后输出到HDFS的文件中。

最后将文件按照分区存储到磁盘,等待Reduce端拉取。每个Reduce拉取Map端对应分区的数据。拉取数据后先存储到内存中,内存不够了,再存储到磁盘。拉取完所有数据后, 采用归并排序将内存和磁盘中的数据都进行排序 。

图3-3 MapReduce任务执行流程示意图 图3-4 Shuffle过程基本流程图 输入的数据执行map任务后,会先写入到本地缓存中(缓存默认大小是100M),缓存数据达到溢写比(默认是0.8)后,会溢写到本地磁盘中。

Java中的HashMap的工作原理是什么?

1、HashMap是基于哈希表的Map接口的非同步实现。此实现提供所有可选的映射操作,并允许使用null值和null键。此类不保证映射的顺序,特别是它不保证该顺序恒久不变。

2、hashmap底层原理是HashMap基于hashing原理,通过put和get方法储存和获取对象。当将键值对传递给put方法时,它调用键对象的hashCode方法来计算hashcode,然后找到bucket位置来储存值对象。

3、HashMap是基于哈希表实现的,而哈希表的底层是数组加上链表的形式。当我们将键值对传递给put()方法时,它调用键对象的 hash Code()方法来计算 hash code,然后找到bucket。

4、总结起来,HashMap的底层原理可以比喻为一个盒子,其中包含很多抽屉。每个抽屉上有一个标签,用来表示抽屉里的物品。当要放入一个键值对时,首先根据键的哈希值找到对应的抽屉,然后将键值对放入抽屉中。

5、hashmap底层实现原理是SortedMap接口能够把它保存的记录根据键排序,默认是按键值的升序排序,也可以指定排序的比较器,当用Iterator遍历TreeMap时,得到的记录是排过序的。如果使用排序的映射,建议使用TreeMap。

6、HashMap的实现原理:首先有一个每个元素都是链表(可能表述不准确)的数组,当添加一个元素(key-value)时,就首先计算元素key的hash值,以此确定插入数组中的位置,但是可能存在同一hash值的元素已经被放在数组同一位置了。

到此,以上就是小编对于map内部实现原理的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏