本篇目录:

hdfs工作流程

mapreduce工作流程如下:输入分片(input split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身。

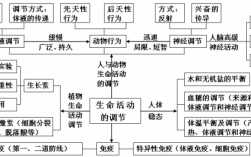

其实,一次mapreduce过程就包括上图的6个步骤,input、splitting、mapping、shuffling、redecing、final redult。

安全模式 在启动namenode至所有datanode启动完成前的阶段成为安全模式。在安全模式下,client只能读取部分HDFS文件信息,不允许client对HDFS的任何更改操作,比如创建目录、上传文件、删除文件、重命名文件等。

MapReduce是一种分布式计算模型,它的计算工作流程如下:输入分片:在进行Map计算之前,MapReduce会根据输入文件计算输入分片,每个输入分片对应一个Map任务,输入分片存储的并非数据本身。

HDFS的文件存储过程?

HDFS中的数据存储通常遵循以下原则来确保数据的安全性: 数据块副本机制:HDFS会将每个文件切分成多个数据块,并为每个数据块创建多个副本。默认情况下,每个数据块会有3个副本存放在不同的DataNode上,以提供容错能力和高可用性。

hdfs的存储过程? ①client向hdfs发起写请求,通过RPC与namenode建立通讯。namenode检查文件是否存在等信息,返回是否可以存储。

HDFS中的文件是以数据块(Block)的形式存储的,默认最基本的存储单位是128 MB(Hadoop x为64 MB)的数据块。

HDFS中的文件在物理上是分块存储(Block),快的大小可以通过配置参数(dfs.blcoksize)来规定,默认大小在Hadoopx中是128M,老版本中是64M。DataNode定期向NameNode 发送心跳报告 已告知自己的状态。

csv数据导入Hadoop中的HDFS

1、Hadoop系列之HDFS架构HadoopDistributedFileSystem(HDFS)是高容错、高吞吐量、用于处理海量数据的分布式文件系统。HDFS一般由成百上千的机器组成,每个机器存储整个数据集的一部分数据,机器故障的快速发现与恢复是HDFS的核心目标。

2、将CSV文件导入数据库的方法有很多种,可以使用脚本、数据库客户端或者数据库提供的管理功能来实现。比如可以在MySQL中使用LOAD DATA INFILE命令,在SQL Server中使用BCP命令,在Oracle中使用SQL*Loader等。

3、例如,使用`LOAD DATA INPATH`命令可以将数据从HDFS中导入到Hive表中。 使用Sqoop导入关系型数据库数据:如果需要将关系型数据库中的数据导入到Hive中,可以使用Sqoop工具。

如何用java程序把本地文件拷贝到hdfs上并显示进度

要将Java文件上传到指定服务器,可以使用以下步骤:使用Java中的Socket类或Java NIO(New IO)库来建立网络连接。

当使用 Java API 操作 HDFS 时,可以使用 FileSystem.listFiles() 方法来获取文件列表。该方法接受一个 Path 对象,表示要列举文件的目录,并返回一个 RemoteIteratorLocatedFileStatus 对象,该对象可用于迭代目录中的文件。

使用java来读写hdfs操作过程中,我们需要对创建好的java文件进行(编译)和执行。

到此,以上就是小编对于往hdfs文件中写入内容命令的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏